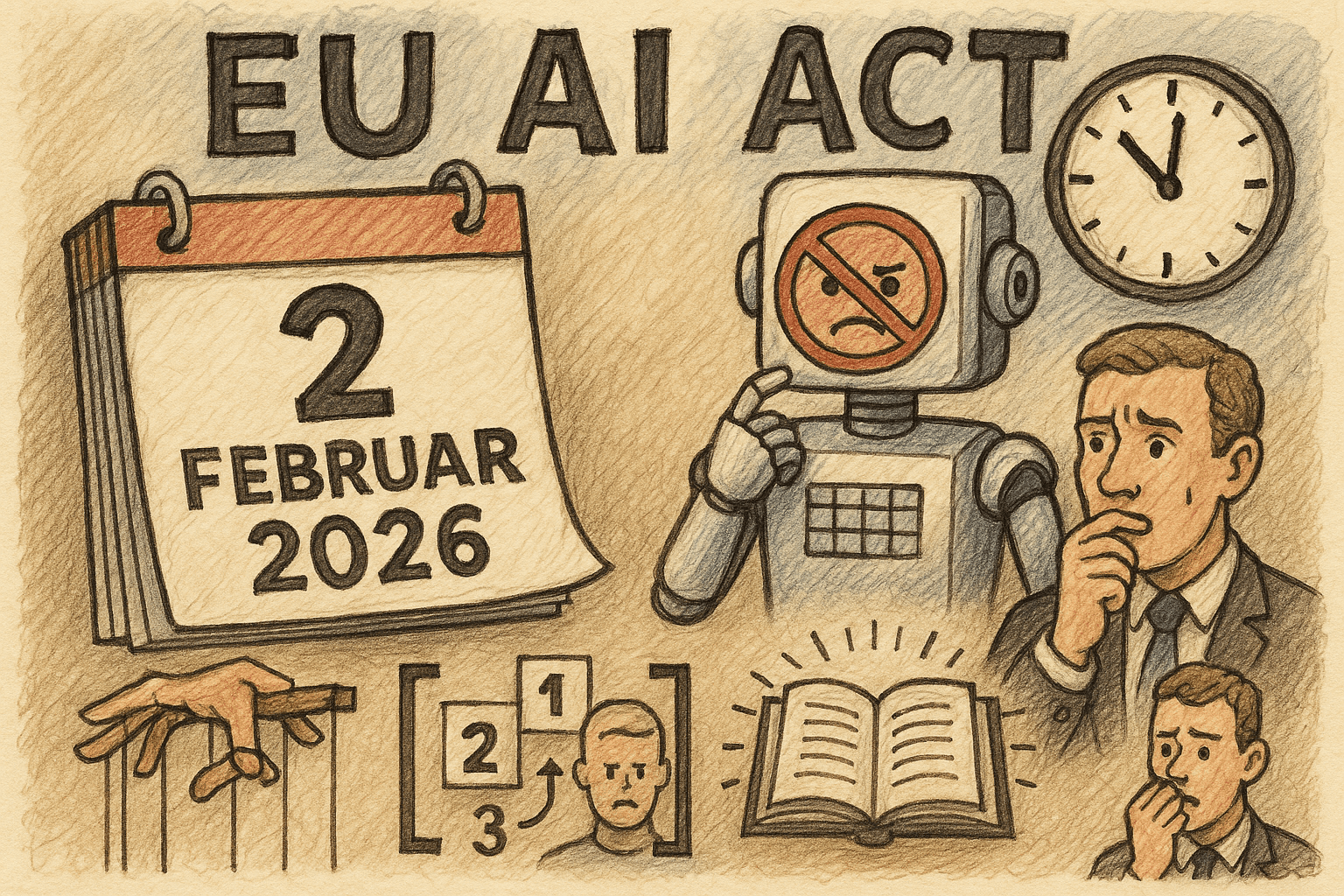

EU AI Act: Verbotene Hochrisiko-Praktiken treten in 24 Stunden in Kraft – was Unternehmen jetzt noch erledigen müssen

01.02.2026

Am 2. Februar 2026 greifen im EU AI Act erstmals die Verbote „inakzeptabler“ KI-Praktiken – darunter manipulative Systeme, Social Scoring und invasive Emotionserkennung – sowie neue Pflichten zur AI-Literacy von Beschäftigten. Unternehmen in der EU (und darüber hinaus, sofern sie den EU-Markt adressieren) haben damit nur noch 24 Stunden Zeit, bestehende KI-Anwendungen auf Verbotsnähe zu prüfen, riskante Use Cases abzuschalten oder anzupassen und kurzfristige Schulungs- und Governance-Maßnahmen aufzusetzen, um Bußgelder von bis zu 7 % des weltweiten Jahresumsatzes zu vermeiden.

EU AI Act: Verbotene Hochrisiko-Praktiken treten in 24 Stunden in Kraft – was Unternehmen jetzt noch erledigen müssen

In 24 Stunden, am 2. Februar 2026, greifen zentrale Verbote des EU AI Act für als „inakzeptabel“ eingestufte KI-Praktiken. Damit endet für Unternehmen faktisch die letzte Schonfrist, um bestehende KI-Systeme auf Compliance zu prüfen. Betroffen sind insbesondere Marketing-, HR-, Sicherheits- und Überwachungsanwendungen sowie KI-gestützte Produktfunktionen.

Dieser Beitrag ordnet ein, welche Praktiken nun untersagt sind, welche neuen Pflichten zur AI-Literacy von Beschäftigten gelten und welche konkreten Schritte Unternehmen innerhalb der nächsten 24 Stunden priorisieren sollten, um regulatorische, finanzielle und Reputationsrisiken zu begrenzen.

Kontext: Was genau am 2. Februar 2026 in Kraft tritt

Der EU AI Act wird konkret

Der EU AI Act ist seit 2024 beschlossene Sache, aber viele Pflichten treten gestaffelt in Kraft. Mit dem 2. Februar 2026 erreicht die Verordnung eine erste kritische Schwelle:

Verbot „inakzeptabler“ KI-Praktiken wird wirksam.

Erste Pflichten zur Förderung von AI-Literacy (KI-Kompetenz) bei Beschäftigten greifen, insbesondere in Organisationen, die Hochrisiko-KI einsetzen oder entwickeln.

Aufsichtsbehörden erhalten eine deutlich klarere Grundlage, um Untersuchungen einzuleiten und Maßnahmen zu verhängen.

Damit endet der überwiegend theoretische Charakter des Gesetzes: KI-Use-Cases werden nun justiziabel, und Unternehmen können sich nicht mehr auf Auslegungsunsicherheiten zurückziehen.

Wer ist betroffen?

Betroffen sind alle Unternehmen und Organisationen, die:

KI-Systeme innerhalb der EU einsetzen oder

KI-gestützte Produkte und Services auf dem EU-Markt anbieten, auch wenn sie ihren Sitz außerhalb der EU haben.

Besonders im Fokus stehen:

B2C-Plattformen und Online-Dienste (E-Commerce, Social, Gaming, Streaming)

Arbeitgeber mit KI-gestützter Personalauswahl, Leistungsbewertung oder Überwachung

Sicherheits- und Überwachungsanbieter, z. B. mit biometrischer Erkennung

Finanzdienstleister und Versicherungen mit Scoring-Ansätzen, die in Richtung Social Scoring driften könnten

Welche KI-Praktiken ab morgen als „inakzeptabel“ verboten sind

Kernverbote des EU AI Act (aus Unternehmensperspektive)

Die Verordnung definiert eine Kategorie „inakzeptables Risiko“, die ab dem Stichtag vollständig untersagt ist. Für Unternehmen besonders relevant:

Manipulative KI-Systeme, die Entscheidungsfreiheit erheblich untergraben

Darunter fallen KI-Anwendungen, die gezielt Schwächen von Personen oder Gruppen ausnutzen, etwa:

- Dark-Pattern-optimierte Empfehlungssysteme, die absichtlich auf Suchtverhalten oder Schuldenanfälligkeit bei bestimmten Nutzern abzielen.

- Adaptive Preis- oder Angebotsgestaltung, die z. B. bei finanziell besonders vulnerablen Gruppen „Druck“ aufbaut, um Abschlüsse zu erzwingen.

KI-gestütztes „Social Scoring“ von Personen durch öffentliche oder private Stellen

Gemeint sind Systeme, die auf Basis umfassender Verhaltens-, Finanz- oder Sozialdaten Gesamtbewertungen der „gesellschaftlichen Zuverlässigkeit“ oder „Wertigkeit“ von Personen vornehmen und diese Scores für wesentliche Entscheidungen nutzen (z. B. Zugang zu Jobs, Krediten, Wohnraum, Dienstleistungen).

Invasive Emotionserkennung in sensiblen Kontexten

Besonders kritisch ist der Einsatz von KI zur Emotionserkennung in:

- Arbeitsverhältnissen (z. B. Kamera- oder Audioanalyse während Meetings, Performance-Bewertungen auf Basis von „Stimmungsprofilen“)

- Bildungsumgebungen (z. B. Proctoring-Tools, die angebliche Nervosität oder Unehrlichkeit aus Gesichtsausdrücken ableiten)

- Weitere Kontexte können – je nach Ausgestaltung in Leitlinien – ebenfalls in den Fokus rücken.

Bestimmte Formen biometrischer Überwachung im öffentlichen Raum

Insbesondere echtzeitfähige biometrische Fernidentifikation (z. B. Gesichtserkennung in öffentlichen Räumen) ist – mit engen Ausnahmen für Strafverfolgung – verboten.

Warum Marketing-, HR- und Security-Use-Cases besonders gefährdet sind

Viele Unternehmen setzen bereits KI in Bereichen ein, die nun sehr nah an die Verbotszone rücken:

Marketing: Systeme, die Nutzer-Schwächen identifizieren („hohe Kaufsucht-Wahrscheinlichkeit“) und gezielt mit aggressiven Angeboten ansprechen, können als manipulative Beeinflussung vulnerabler Gruppen gewertet werden.

HR: Tools, die Verhaltensdaten, Mikromimik oder Sprachmuster aus Interviews analysieren und daraus ein „Cultural Fit“- oder „Loyalitätsscore“ ableiten, kommen Social Scoring und verbotener Emotionserkennung gefährlich nahe.

Sicherheit / Compliance: KI-basierte Videoanalysen im Büro, die Mitarbeitende kontinuierlich auf „Anzeichen von Unzufriedenheit“ oder „Betrugsverdacht“ scannen, riskieren einen klaren Verstoß gegen das Verbot invasiver Emotionserkennung.

Neue Pflicht: AI-Literacy für Beschäftigte

Was unter AI-Literacy zu verstehen ist

Parallel zu den Verboten treten verstärkt Pflichten zur Förderung von KI-Kompetenz in Kraft – insbesondere für Organisationen, die:

Hochrisiko-KI entwickeln oder betreiben oder

KI in wesentlichen Geschäftsprozessen (HR, Kreditvergabe, kritische Infrastrukturen, Gesundheit, Bildung) einsetzen.

AI-Literacy umfasst dabei mindestens:

Grundverständnis, wie relevante KI-Systeme funktionieren und welche Datentypen sie nutzen.

Kenntnis der Risiken und Grenzen, etwa mögliche Verzerrungen und Fehlklassifikationen.

Befähigung, Ergebnisse zu hinterfragen, anstatt KI-Ausgaben blind zu akzeptieren.

Kenntnis der eigenen Verantwortlichkeiten, z. B. wann der Mensch eingreifen, eskalieren oder dokumentieren muss.

Wer konkret geschult werden muss

Fachbereiche, die mit Hochrisiko-KI arbeiten (z. B. HR, Risk, Underwriting, Security, Operations).

Entwicklungs- und Data-Science-Teams, die Modelle trainieren, konfigurieren oder integrieren.

Management und Projektverantwortliche, die Entscheidungen treffen, in denen KI-Ergebnisse eine wesentliche Rolle spielen.

Ein rein technisches Training reicht nicht aus. Gefordert ist eine rollenbezogene Schulung, die sowohl rechtliche Anforderungen als auch praktische Alltagssituationen abdeckt.

Detaillierte Analyse: Auswirkungen, Risiken und Chancen

Unmittelbare Risiken ab Stichtag

Regulatorische Risiken

- Bußgelder von bis zu 7 % des weltweiten Jahresumsatzes bei schweren Verstößen.

- Untersagungsverfügungen für bestimmte KI-Systeme oder -Prozesse.

- Untersuchungen durch Aufsichtsbehörden, insbesondere bei Beschwerden von Beschäftigten oder Verbraucherorganisationen.

Arbeits- und datenschutzrechtliche Angreifbarkeit

- KI-Systeme, die Emotionen, Verhalten oder „Charakter“ von Beschäftigten bewerten, können zusätzlich gegen Arbeitsrecht, Datenschutz (DSGVO) und Betriebsverfassungsrecht verstoßen.

- Kollektivvertretungen (Betriebsräte) erhalten eine stärkere Position, Einsicht und ggf. Abschaltung solcher Systeme zu verlangen.

Reputationsschäden

- Fälle von „KI-Missbrauch“ in HR, Marketing oder Überwachung werden medial schnell aufgegriffen.

- Vertrauen von Mitarbeitenden, Kunden und Partnern kann nachhaltig beschädigt werden, wenn bekannt wird, dass verbotene Praktiken eingesetzt wurden.

Mittel- bis langfristige Chancen

Trotz des sehr engen Zeitfensters birgt der Stichtag auch Chancen:

Bereinigung des Use-Case-Portfolios: Unternehmen werden gezwungen, riskante, schwer erklärbare und rechtlich fragwürdige KI-Anwendungen zu eliminieren.

Stärkung von Vertrauen und Marke: Wer transparent mit KI umgeht, manipulative Praktiken vermeidet und die Rechte von Nutzern und Mitarbeitenden achtet, baut Vertrauen auf.

Professionalisierung von KI-Governance: Notwendige Strukturen (Risikoklassen, Freigabeprozesse, Schulungspflichten) schaffen eine Grundlage für nachhaltige Skalierung von KI.

Praxisbeispiele: Wo Unternehmen jetzt sofort hinschauen müssen

Beispiel 1: E-Commerce und personalisierte Angebote

Ein großer Online-Händler nutzt ein KI-System, das Nutzerdaten aus Käufen, Klickverläufen, Interaktionen mit dem Support und externen Datenquellen kombiniert. Die KI klassifiziert Nutzer u. a. als:

„preisunempfindlich“

„hohe Rückfallgefahr zu Konkurrenz“

„suchtgefährdetes Kaufverhalten“

Auf Basis dieser Segmente werden personalisierte Angebote, Push-Nachrichten und Rabatte ausgespielt.

Risikopunkt:

Sobald die KI gezielt psychologisch verwundbare Nutzergruppen identifiziert (z. B. Suchtverhalten, hohe Verschuldung) und aggressiv zum Kauf animiert, kann dies als inakzeptable manipulative Praxis bewertet werden.

Kurzfristige Maßnahmen (nächste 24 Stunden):

Deaktivierung gezielter Kampagnen, die auf solche sensiblen Merkmale zugreifen.

Anpassung der Segmentierungslogik – keine Profile auf Basis von Sucht, Schulden oder sonstiger vulnerabler Merkmale.

Dokumentation, wie das Empfehlungssystem funktioniert und welche Daten nicht mehr für manipulative Zwecke genutzt werden.

Beispiel 2: KI-basiertes Video-Interview im Recruiting

Ein Unternehmen setzt ein KI-Tool ein, das Video-Interviews automatisch auswertet. Das System erstellt Scores unter anderem aus:

Mimik- und Stimmanalyse („Selbstbewusstsein“, „Stresslevel“, „Emotionale Stabilität“)

Sprachmustern („Durchsetzungsfähigkeit“, „Teamorientierung“)

Aus diesen Daten wird ein Gesamt-Eignungsscore berechnet, der im Auswahlprozess stark gewichtet wird.

Risikopunkt:

Emotionserkennung im HR-Kontext ist besonders kritisch und kann in die Kategorie verbotener invasiver Praktiken fallen.

Die Kombination zu einem umfassenden „Persönlichkeits- oder Zuverlässigkeitsscore“ kommt Social Scoring sehr nahe.

Kurzfristige Maßnahmen:

Sofortige Deaktivierung aller Emotionserkennungsfunktionen im HR-Kontext.

Übergang auf ein Modell, das ausschließlich auf nachvollziehbaren, aufgabenbezogenen Kriterien basiert.

Information an HR, dass Scores aus der alten Version nicht mehr verwendet werden dürfen.

Beispiel 3: Office-Überwachung mit KI-Videoanalyse

Ein Unternehmen überwacht Büros mit Kameras, deren Feeds von einer KI analysiert werden. Ziel ist es, „Anzeichen von Unzufriedenheit, Inaktivität oder Illoyalität“ bei Mitarbeitenden zu erkennen, um frühzeitig Personalrisiken zu identifizieren.

Risikopunkt:

Dies ist ein Lehrbuchbeispiel für invasive Emotionserkennung und möglicherweise Profilbildung, die klar in der Verbotszone liegt.

Kurzfristige Maßnahmen:

Sofortige Abschaltung der Emotionserkennungs-Module.

Prüfung, ob die verbleibende Videoüberwachung rein sicherheitsbezogene Zwecke verfolgt (z. B. Zutrittskontrolle, Diebstahlprävention) und sich innerhalb anderer Rechtsrahmen (DSGVO, Arbeitsrecht) bewegt.

Was Unternehmen innerhalb der nächsten 24 Stunden tun sollten

1. KI-Inventur fokussiert auf Verbotsnähe

Erstellen Sie eine Schnell-Inventur Ihrer KI-Anwendungen mit Fokus auf folgende Fragen:

Wo setzen wir Emotionserkennung, Verhaltensprofiling oder psychologische Segmentierung ein?

Wo bewertet ein System Menschen in ihrer „gesellschaftlichen Wertigkeit“, „Zuverlässigkeit“ oder „Loyalität“?

Wo wird explizit auf vulnerable Gruppen ausgerichtet (Kinder, Erkrankte, Hochverschuldete, Suchtgefährdete etc.)?

Gibt es KI-Systeme, die Echtzeit-Biometrie im öffentlichen oder halböffentlichen Raum einsetzen?

Ergebnisse sollten tabellarisch erfasst werden (System, Zweck, Datenarten, Nutzergruppe, verantwortlicher Owner).

2. Sofortige Stop-or-Change-Entscheidungen

Für identifizierte kritische Use Cases braucht es binäre Entscheidungen:

Stop: Sofortige Abschaltung oder Deaktivierung klar verbotener Funktionen (Emotionserkennung in HR, Social Scoring, manipulative Dark-Pattern-Optimierung).

Change: Übergangsweise Funktionsreduktion oder -anpassung, um den Einsatz auf zulässige Zwecke zu begrenzen (z. B. reine Betrugserkennung, Sicherheitsüberwachung ohne Emotionserkennung).

Wichtig: Änderungen sollten dokumentiert werden, um Behörden bei Nachfragen nachweisen zu können, dass Maßnahmen vor dem Stichtag umgesetzt wurden.

3. Kurzfristige AI-Literacy-Maßnahmen

Innerhalb der kommenden 24 Stunden sind keine umfassenden Trainingsprogramme realistisch – aber Mindestmaßnahmen sind möglich und sinnvoll:

Komprimierte Briefings (z. B. 30–60 Minuten Online-Sessions) für:

- HR-Leitung und Recruiting-Teams

- Marketing- und Produktverantwortliche

- Security- und Compliance-Verantwortliche

Inhaltliche Schwerpunkte:

- Welche KI-Praktiken ab 2. Februar 2026 verboten sind

- Beispiele aus dem eigenen Unternehmen (wo wir nah an der Grenze sind oder waren)

- Klare Handlungsanweisungen: Was ist ab sofort untersagt? Wann muss eskaliert werden?

Diese kurzfristigen Maßnahmen bilden die Basis für ein strukturiertes, mittel- und langfristiges AI-Literacy-Programm.

4. Governance-Struktur skizzieren

Auch wenn die vollständige Implementierung mehr Zeit braucht, sollten Unternehmen jetzt zumindest Grundzüge einer KI-Governance definieren:

Wer entscheidet künftig über die Einführung neuer KI-Systeme?

Welche Risikoklassen werden verwendet (z. B. basierend auf den Kategorien des EU AI Act)?

Welche Freigabeschritte sind vor Live-Gang erforderlich (z. B. Privacy-Check, Ethics-Check, Betriebsratsbeteiligung)?

Eine kurze „Interim-Richtlinie“ kann ausreichen, um zu zeigen, dass das Unternehmen verantwortungsvoll handelt und Compliance ernst nimmt.

5. Kommunikation und Dokumentation

Interne Kommunikation: Klar und verständlich erläutern, welche Systeme geändert oder abgeschaltet werden und warum.

Externe Kommunikation (wo nötig): Bei Produkten oder Services, die gegenüber Kunden angepasst werden, sollten Änderungen transparent gemacht werden.

Dokumentation: Alle Entscheidungen, Bewertungen und Maßnahmen in einem Audit-Log festhalten (Datum, verantwortliche Person, Begründung, technische Umsetzung).

Business-Relevanz: Strategische Implikationen für Unternehmen

Von „Experimentierfreude“ zu regulierter Skalierung

Der Stichtag markiert den Übergang von einer Phase, in der KI-Projekte häufig experimentell und opportunistisch umgesetzt wurden, zu einer Phase, in der Compliance und Governance zentrale Erfolgsfaktoren sind.

Unternehmen, die jetzt:

Transparenz über ihre KI-Landschaft herstellen,

kritische Use Cases konsequent bereinigen und

AI-Literacy systematisch aufbauen,

werden langfristig robuster, vertrauenswürdiger und wettbewerbsfähiger sein als Organisationen, die nur reaktiv Mindestanforderungen erfüllen.

Wettbewerbsvorteil durch verantwortungsvollen KI-Einsatz

In vielen Branchen wird KI mittelfristig zum Standard. Differenzierung entsteht dann nicht mehr nur über die technologischen Fähigkeiten, sondern darüber,

wie gut Unternehmen Risiken managen,

wie transparent sie mit Betroffenen umgehen und

wie sie Mitarbeitende einbinden.

Wer heute die Verbotsgrenze des EU AI Act ernst nimmt, signalisiert Kunden, Partnern und Talenten, dass KI nicht gegen, sondern für Menschen eingesetzt wird.

Fazit: Was jetzt zu tun ist

Mit dem morgigen Inkrafttreten der Verbote für inakzeptable KI-Praktiken im EU AI Act endet die Phase des „Abwartens“. Unternehmen müssen jetzt innerhalb von Stunden handeln, nicht innerhalb von Monaten.

Zentrale Takeaways für die nächsten 24 Stunden

Schnell-Inventur durchführen: Alle KI-Systeme identifizieren, die Menschen bewerten, Emotionen erkennen, Verhalten profilieren oder vulnerable Gruppen gezielt adressieren.

Verbotene Praktiken stoppen: Emotionserkennung in HR und Bildung, Social-Scoring-Ansätze und manipulative, auf Schwächen zielende Systeme unverzüglich deaktivieren oder tiefgreifend umbauen.

AI-Literacy kurzfristig anstoßen: Kritische Rollen (HR, Marketing, Security, Management) in kompakten Formaten über Verbote, Risiken und neue Verantwortlichkeiten informieren.

Interim-Governance etablieren: Vorläufige Richtlinien und Entscheidungsprozesse definieren, um künftige KI-Projekte frühzeitig auf Verbotsnähe zu prüfen.

Dokumentation und Kommunikation sichern: Alle Entscheidungen nachvollziehbar dokumentieren und betroffene Stakeholder transparent über Änderungen informieren.

Strategische Perspektive einnehmen: Die aktuelle Krisenphase nutzen, um eine belastbare, langfristige KI-Governance aufzubauen – als Basis für vertrauenswürdige KI-Innovation im Rahmen des EU AI Act.

Häufig gestellte Fragen (FAQ)

Was ändert sich konkret mit dem EU AI Act am 2. Februar 2026?

Am 2. Februar 2026 treten im EU AI Act erstmals die Verbote für als „inakzeptabel“ eingestufte KI-Praktiken in Kraft, etwa manipulative Systeme, Social Scoring und invasive Emotionserkennung. Gleichzeitig beginnen Pflichten zur Förderung von AI-Literacy für Beschäftigte, insbesondere in Organisationen, die Hochrisiko-KI entwickeln oder einsetzen.

Welche KI-Praktiken sind nach dem EU AI Act als „inakzeptabel“ verboten?

Verboten sind unter anderem manipulative KI-Systeme, die gezielt Schwächen von Personen oder vulnerablen Gruppen ausnutzen, sowie KI-basiertes Social Scoring von Personen durch öffentliche und private Stellen. Ebenfalls untersagt sind invasive Emotionserkennung in sensiblen Kontexten wie Arbeit und Bildung sowie bestimmte Formen biometrischer Fernidentifikation im öffentlichen Raum.

Welche Unternehmen sind vom EU AI Act und den neuen Verboten besonders betroffen?

Betroffen sind alle Unternehmen, die KI-Systeme in der EU einsetzen oder KI-gestützte Produkte und Services auf dem EU-Markt anbieten – auch wenn sie ihren Sitz außerhalb der EU haben. Besonders im Fokus stehen B2C-Plattformen, Arbeitgeber mit KI im HR-Bereich, Sicherheits- und Überwachungsanbieter sowie Finanzdienstleister und Versicherungen mit Scoring-Ansätzen.

Was bedeutet AI-Literacy und wen müssen Unternehmen schulen?

AI-Literacy beschreibt die grundlegende Kompetenz von Beschäftigten, relevante KI-Systeme zu verstehen, ihre Risiken und Grenzen zu kennen und Ergebnisse kritisch einordnen zu können. Geschult werden sollten insbesondere Fachbereiche mit Hochrisiko-KI (z. B. HR, Risk, Security), Entwickler- und Data-Science-Teams sowie Management und Projektverantwortliche.

Welche Risiken drohen Unternehmen bei Verstößen gegen die Verbote des EU AI Act?

Unternehmen riskieren Bußgelder von bis zu 7 % des weltweiten Jahresumsatzes, Untersagungsverfügungen für bestimmte KI-Systeme und Untersuchungen durch Aufsichtsbehörden. Zusätzlich drohen arbeits- und datenschutzrechtliche Verfahren sowie erhebliche Reputationsschäden, wenn verbotene KI-Praktiken öffentlich werden.

Was sollten Unternehmen innerhalb der nächsten 24 Stunden vor Inkrafttreten tun?

Unternehmen sollten eine fokussierte KI-Inventur durchführen, kritische Use Cases identifizieren und verbotsnahe oder eindeutig verbotene Funktionen sofort abschalten oder anpassen. Parallel sind Kurzbriefings zur AI-Literacy für Schlüsselrollen sowie erste Governance-Regeln, Dokumentation der Maßnahmen und transparente interne Kommunikation erforderlich.

Wie unterscheiden sich verbotene manipulative KI-Praktiken von zulässigem personalisiertem Marketing?

Zulässiges personalisiertes Marketing basiert auf üblichen Nutzerdaten und Interessen, ohne gezielt psychologische Verwundbarkeiten auszunutzen. Verboten wird es, wenn KI bewusst auf Suchtverhalten, Überschuldung oder andere Formen besonderer Verwundbarkeit zielt, um Entscheidungen zu erzwingen oder die Entscheidungsfreiheit erheblich zu untergraben.